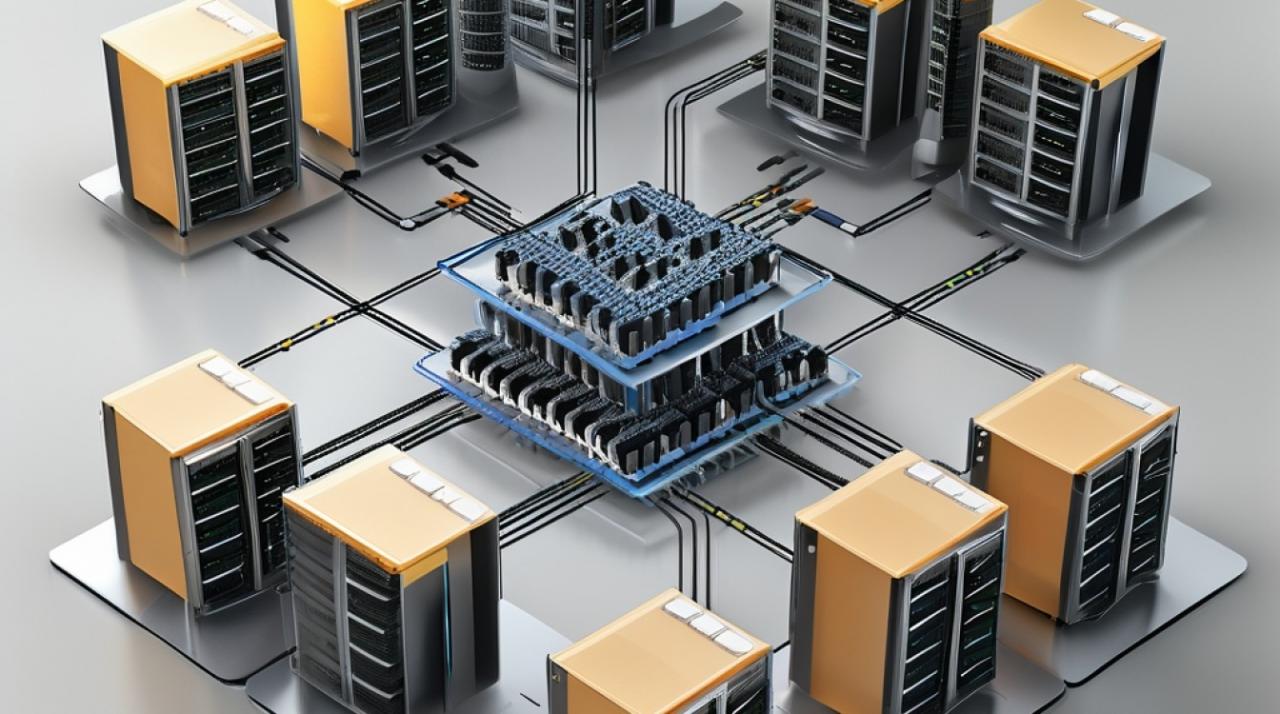

负载均衡总体架构

一、引言

在现代计算机科学中,负载均衡(Load Balancing)是一项关键的技术,用于实现高性能、高可用性和可扩展性的系统架构,随着互联网用户数量和数据量的激增,单点服务器已经无法满足大量请求的处理需求,通过负载均衡,可以将请求分摊到多台服务器上,从而提升系统的整体性能和可靠性,本文将详细介绍负载均衡的概念、类型、算法以及实际应用中的部署方式。

二、负载均衡

定义与目标

负载均衡是一种将工作任务分配到多个操作单元上的技术手段,主要目的是:

提高系统处理能力:通过并行处理,提升系统吞吐量。

增强系统可靠性:避免单点故障,确保高可用性。

提升系统扩展性:方便地添加或减少服务器数量,适应动态变化的负载需求。

核心问题

负载均衡解决两个核心问题:

选谁:选择哪台服务器来处理请求。

转发:如何将请求从一个服务器转发到另一个服务器。

三、负载均衡的类型

根据实现技术和应用场景的不同,负载均衡可以分为以下几类:

DNS负载均衡

1.1 概念

DNS负载均衡通过域名解析实现请求的分配,在DNS服务器中,为同一个域名配置多个IP地址,当客户端发起请求时,DNS服务器根据预设策略返回其中一个IP地址。

1.2 优点

实现简单,适用于地理级别的负载均衡。

能够根据用户的地理位置解析最近的服务器IP,提升访问速度。

1.3 缺点

DNS缓存可能导致负载不均。

不支持复杂的负载均衡策略。

硬件负载均衡

2.1 概念

硬件负载均衡使用专用设备(如F5、A10)来实现请求的分发,这些设备具备高性能和丰富的功能,但成本较高。

2.2 优点

支持各种负载均衡算法。

能够处理大量并发连接(通常支持百万级并发)。

集成防火墙、防DDOS攻击等功能。

2.3 缺点

价格昂贵。

配置和维护复杂。

软件负载均衡

3.1 概念

软件负载均衡通过安装软件(如Nginx、HAProxy)在普通服务器上实现请求的分发,相比硬件负载均衡,软件负载均衡成本较低,灵活性高。

3.2 优点

成本低。

部署和维护相对简单。

灵活性高,可以根据需求定制功能。

3.3 缺点

性能较硬件负载均衡略逊一筹。

通常不具备防火墙和防DDOS攻击等高级功能。

链路层负载均衡

4.1 概念

链路层负载均衡工作在OSI模型的第二层(数据链路层),通过修改MAC地址进行请求分发,这种方式也称为直接路由模式(DR模式)。

4.2 优点

性能好,因为数据包不需要经过多次封装和解封装。

配置相对简单。

4.3 缺点

只适用于特定网络环境,不适合大规模公网应用。

需要特定的硬件支持。

四、负载均衡算法

轮询(Round Robin)

轮询算法按顺序将请求依次分配给每台服务器,循环往复,该算法简单易实现,但没有考虑服务器的性能差异。

2. 加权轮询(Weighted Round Robin)

加权轮询在轮询的基础上引入权重因子,根据服务器性能分配不同比例的请求,高性能服务器分配更高的权重。

3. 最少连接数(Least Connections)

最少连接数算法将新请求分配给当前连接数最少的服务器,以均衡各服务器的负载,这种算法适用于长时间连接的场景,如数据库连接。

4. 源地址哈希(Source IP Hashing)

源地址哈希算法通过对客户端IP地址进行哈希运算,确定请求分配到哪台服务器,这可以保证来自同一客户端的请求总是被分配到同一台服务器,保持会话粘性。

5. 最短响应时间(Shortest Response Time)

最短响应时间算法将请求分配给响应时间最短的服务器,以优化用户体验,这种算法需要实时监测服务器的响应时间。

五、实际应用中的部署方式

直连模式结构

直连模式结构中,负载均衡设备位于客户端和服务器之间,使用公开的IP地址接收请求,然后将请求转发给后端服务器,这种部署方式适用于大多数场景,易于实现和管理。

旁路部署

旁路部署中,负载均衡设备位于交换机旁边,与交换机连接的所有服务器共享同一个公开IP地址,所有流量都经过负载均衡设备,再由其转发给相应的服务器处理,这种部署方式适用于需要细粒度控制的网络环境。

双机热备

双机热备部署方式中,两台负载均衡设备互为备份,确保高可用性,当主设备故障时,备份设备自动接管工作,保证服务的连续性,这种部署方式适用于对高可用性要求极高的场景。

六、归纳与展望

负载均衡作为提升系统性能和可靠性的重要技术,已经在各类互联网服务中得到广泛应用,通过合理选择负载均衡类型和算法,结合实际业务需求进行部署,可以显著提升系统的整体表现,随着云计算和大数据技术的发展,负载均衡技术将不断进步和完善,为构建更高效、更稳定的系统架构提供更多可能性。

以上就是关于“负载均衡总体架构”的问题,朋友们可以点击主页了解更多内容,希望可以够帮助大家!