负载均衡数据链路层转发

背景介绍

在现代计算机网络中,负载均衡是一种关键的技术,用于分配工作负载和优化资源使用,它通过分散流量到多个服务器,确保没有单个服务器过载,从而提高系统的整体性能和可靠性,本文将详细探讨负载均衡在数据链路层的转发机制。

什么是数据链路层?

数据链路层是OSI模型的第二层,负责在相邻节点之间可靠地传输数据帧,这一层主要处理MAC地址寻址、错误检测和纠正、以及流量控制等功能,数据链路层协议如以太网协议在局域网(LAN)中广泛使用,而广域网(WAN)则可能使用PPP或HDLC等协议。

负载均衡的基本概念

负载均衡是一种通过多台服务器分散客户请求的技术,旨在优化资源使用,最大化吞吐量,最小化响应时间,并避免任何单一资源的过载,负载均衡器通常作为反向代理或网关,接收来自客户端的请求,并根据预定义的规则将这些请求分配给后端服务器群中的某一台服务器。

数据链路层负载均衡的特点

数据链路层负载均衡主要涉及MAC地址的修改,通过这种方式实现流量的分配,以下是这种负载均衡方式的一些特点:

高效性:由于数据链路层的操作相对简单,不涉及复杂的IP地址解析和修改,因此具有较高的处理效率。

低延迟:直接在链路层进行转发,减少了处理时延,提高了响应速度。

可扩展性:可以根据需要动态调整服务器集群的配置,轻松添加或移除服务器。

透明性:对应用层完全透明,不需要修改应用程序代码即可实现负载均衡。

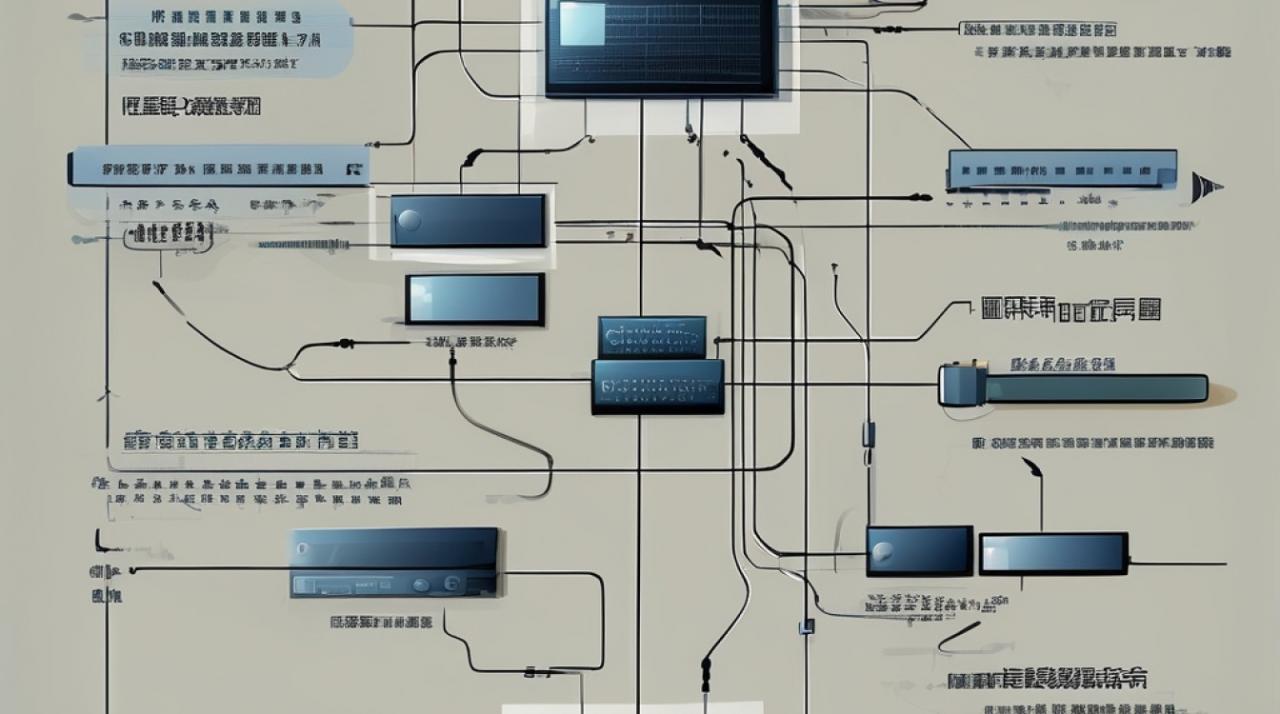

数据链路层负载均衡的工作原理

1. 三角传输模式(Triangle Mode)

在这种模式下,负载均衡器只修改数据帧中的MAC地址,将请求直接转发给目标服务器,而目标服务器的响应直接返回给客户,绕过了负载均衡器,具体过程如下:

请求阶段:客户端发送请求到虚拟IP地址(VIP),负载均衡器接收到请求后,将数据帧的目的MAC地址更改为目标服务器的MAC地址,并将请求转发给该服务器。

响应阶段:目标服务器处理完请求后,直接将响应返回给客户端,而不经过负载均衡器。

这种模式的优点是减少了负载均衡器的负担,但其缺点是需要所有真实服务器的虚拟IP地址与负载均衡器的虚拟IP地址一致,且它们必须位于同一个子网内。

2. 直接路由模式(Direct Routing)

直接路由模式类似于三角传输模式,但更加灵活,它可以配置真实服务器的虚拟IP地址与负载均衡器的虚拟IP地址不同,从而允许跨子网通信,具体过程如下:

请求阶段:客户端发送请求到虚拟IP地址(VIP),负载均衡器接收到请求后,将数据帧的目的MAC地址更改为目标服务器的MAC地址,并将请求转发给该服务器。

响应阶段:目标服务器处理完请求后,将响应直接返回给客户端,而不经过负载均衡器。

这种模式的优点是可以跨子网通信,但其缺点是配置较为复杂,需要确保路由信息正确。

链路聚合控制协议(LACP)

LACP是一种用于聚合多个物理端口到一个逻辑链路的协议,常用于提高带宽和提供冗余路径,在负载均衡中,LACP可以帮助实现链路级的负载均衡,具体过程如下:

链路聚合:多个物理链路被聚合成一个逻辑链路,形成一个更大的传输通道。

流量分配:根据预设的策略(如轮询、加权轮询等),将流量分配到不同的物理链路上。

故障恢复:如果某个物理链路出现故障,LACP会自动将流量转移到其他可用链路,确保通信不中断。

数据链路层负载均衡的应用场景

高性能计算环境:如数据中心、云计算平台等,需要高效的流量分配和低延迟的响应。

大规模Web服务:如电商平台、社交媒体网站等,需要处理大量并发请求,确保用户体验。

实时通信系统:如视频会议、在线游戏等,对延迟敏感的应用,需要快速的流量转发。

企业内部网络:如办公自动化系统、ERP系统等,需要可靠的内部通信和资源共享。

数据链路层负载均衡的优势与劣势

优势

高效性:数据链路层的处理速度快,能够迅速响应客户端请求。

低延迟:直接在链路层进行转发,减少了处理时延。

可扩展性:可以根据需求动态调整服务器集群的配置。

透明性:对应用层完全透明,无需修改应用程序代码。

劣势

配置复杂:需要确保真实服务器的虚拟IP地址与负载均衡器的虚拟IP地址一致,且必须位于同一个子网内。

跨子网限制:直接路由模式虽然可以跨子网通信,但配置较为复杂。

依赖硬件支持:某些高级功能可能需要特定的硬件支持。

数据链路层负载均衡是一种高效的流量分配机制,适用于高性能计算环境和大规模Web服务等场景,通过修改MAC地址实现流量转发,具有高效性、低延迟和可扩展性等优点,其配置相对复杂,且存在一定的跨子网限制,在实际应用中,需要根据具体需求选择合适的负载均衡策略,并合理配置服务器集群以实现最佳性能。

小伙伴们,上文介绍了“负载均衡数据链路层转发”的内容,你了解清楚吗?希望对你有所帮助,任何问题可以给我留言,让我们下期再见吧。